Inteligencia artificial e integridad de la información: experiencias latinoamericanas

Documento de Política Nº 34, 2025

La inteligencia artificial (IA) podría remodelar el panorama electoral de América Latina al exacerbar aún más los problemas existentes por la forma en que se crea, selecciona y difunde la información. Los avances en el procesamiento del lenguaje natural, arquitectura basada en transformers [transformer-based architecture] y el acceso generalizado a grandes conjuntos de datos han dado lugar a potentes aplicaciones de IA. Si bien la IA mantiene la promesa de un fomento de la participación cívica, el impulso del desarrollo económico y una mejora potencial de los procesos democráticos, también presenta riesgos profundos para la integridad de la información, especialmente en lo que respecta a las elecciones.

Este documento analiza el creciente papel de la IA en procesos electorales latinoamericanos, centrándose especialmente en sus implicaciones para las elecciones y los grupos marginados. Analiza los usos de la IA en cuatro niveles (creación, curación y moderación de contenidos, así como publicidad política) y documenta su presencia desigual pero en expansión en las elecciones de 2024 en Brasil y México. Los estudios de caso de las elecciones en ambos países revelan la utilización de la IA generativa tanto para engañar como para convencer, incluso a través de deepfakes, contenido de audio manipulado y chatbots impulsados por IA. Especialmente preocupante es el uso de la IA para amplificar la violencia política de género. En tanto las candidatas femeninas y LGBTQIA+ son objeto de ataques desproporcionados a través de contenidos no consentidos y degradantes.

El informe también analiza los marcos de políticas regionales y mundiales en materia de IA. El estudio concluye que, si bien muchos de estos marcos reconocen la necesidad de supervisión y transparencia humanas, la mayoría descuida áreas clave: la manipulación electoral impulsada por la IA, la amplificación algorítmica de contenido dañino, los perjuicios de género y la monetización de la desinformación. Las estrategias de IA en América Latina suelen ser difusas o silenciosas, especialmente cuando se trata de las consecuencias electorales de la IA y su impacto en las comunidades marginadas.

Para mitigar los riesgos asociados al uso de inteligencia artificial en los procesos electorales, el documento recomienda que las plataformas aumenten su transparencia. Esto incluye divulgar los conjuntos de datos utilizados para entrenar los algoritmos y explicar por qué cierto contenido se muestra a determinados usuarios. Asimismo, se sugiere promover valores democráticos, como el pluralismo mediático y la diversidad de opiniones, al tiempo que se limitan las prácticas abusivas en el uso de datos. Por otro lado, clarificar los estándares editoriales aplicables al contenido generado por IA y permitir auditorías independientes sobre los datos de las plataformas puede contribuir a evitar una amplificación algorítmica no intencionada o perjudicial. Finalmente, renovar la confianza pública en las instituciones democráticas y fortalecer el Estado de derecho son condiciones esenciales para proteger los procesos electorales frente a los efectos negativos de la IA sobre la integridad de la información, y para garantizar que todas las voces—en especial las de comunidades marginadas—sean escuchadas y representadas.

La influencia actual de la IA sobre las elecciones en América Latina sigue siendo limitada, pero su potencial disruptivo es real y creciente. El fortalecimiento de las instituciones democráticas, la mejora de los marcos regulatorios y la equidad en la gobernanza digital son cuestiones esenciales para proteger la integridad electoral en la era de la IA.

La integridad del entorno informativo ha sido una cuestión decisiva para las elecciones en América Latina —y a nivel mundial— en los últimos años. Los actores políticos han buscado, con mayor o menor éxito, distorsionar el ecosistema de información durante las elecciones para adquirir o retener el poder. Tales actores han convertido las divisiones sociales en un arma, explotando los nuevos canales y posibilidades creados por las plataformas digitales. Han inundado la esfera pública digital con información y relatos, utilizando a menudo técnicas no auténticas o ilícitas, para promover sus intereses, erosionando la confianza en el proceso electoral. Al hacerlo, han mermado la capacidad de las elecciones para captar con precisión las preocupaciones y opiniones de los ciudadanos y transformarlas en políticas —una queja de larga data en toda América Latina—, lo que está alimentando una creciente desconfianza y desvinculación de la democracia. De Argentina a México y de Brasil a El Salvador, la contaminación del entorno informativo representa un desafío definitorio para la democracia en todo el continente.

El problema va más allá de la difusión de información falsa o inexacta: implica la manipulación del ecosistema informativo para amplificar ciertos discursos políticos, dirigir la agenda y el debate político, y normalizar o legitimar ideas y políticas que, hasta hace poco, quedaban al margen del discurso político. Esta manipulación crea realidades a medida para ciertos grupos de ciudadanos; realidades que no se basan en hechos ni en un intercambio pacífico de ideas, sino en información y relatos manipulados que benefician a ciertos sectores políticos. En América Latina, la subversión del ecosistema de la información se ha basado en la falta de confianza en los medios de comunicación, en parte como consecuencia de la concentración de la propiedad de los medios, y en la creciente hostilidad a la que se enfrentan los periodistas (Mont’Alverne et al., 2021). La combinación de estos fenómenos fractura las sociedades al socavar un requisito fundamental para el funcionamiento democrático: la existencia de una visión compartida de la realidad, basada en información fiable.

Las elecciones no pueden cumplir su función sin una base común de hechos. Los candidatos y sus campañas han explotado estratégicamente la erosión de esa realidad compartida para cuestionar tanto la legitimidad de los resultados electorales como la fiabilidad de los organismos responsables de administrarlos. En todo el continente, muchos actores políticos han intentado construir una realidad alternativa para sus seguidores, en la que solo ellos se presentan como una fuerza política legítima, mientras que cualquier alternativa es etiquetada como antidemocrática. Esto, irónicamente, suele manifestarse en intentos de deslegitimar el propio proceso electoral. Al minar la integridad electoral, estos actores socavan la legitimidad del gobierno y profundizan la fragmentación social. Además, el debate político sobre cómo enfrentar los desafíos que se avecinan en la región—desde el cambio climático hasta la desigualdad o la corrupción—sigue siendo confuso y carece de una dirección clara para avanzar.

Las consecuencias se han dejado sentir en toda la región. En Brasil, años de ataques coordinados contra el sistema electoral culminaron en un fallido golpe de Estado tras las elecciones generales de 2022 (Souza, 2024). En Perú, el cuestionamiento infundado de los resultados de las elecciones generales de 2021 provocó días de protestas y ahondó la crisis de confianza en el sistema. En toda la región, los resultados electorales son frecuentemente cuestionados, siguiendo una tendencia global (IDEA Internacional, 2024). Los líderes autoritarios han ascendido o consolidado su poder en países como El Salvador, Nicaragua y Venezuela.

En este sombrío contexto, el rápido auge de la inteligencia artificial ha introducido nuevas y complejas amenazas contra la ya erosionada integridad de la información durante las elecciones. Aunque todavía se halle en sus inicios, la IA, en particular la IA generativa, tiene potencial de convertirse en una herramienta poderosa para aquellos que buscan distorsionar el panorama de la información. Como se observa en los estudios de caso de Brasil y México, a medida que la IA generativa mejora, se vuelve cada vez más capaz de producir texto, imágenes, audio y video engañosos, lo que debilita aún más la fortaleza de una visión compartida entre los ciudadanos. La IA no solo puede convencer a los ciudadanos de una realidad alternativa, sino también distribuirla directamente a las pantallas de sus teléfonos. De manera alarmante, todavía no existe un método fiable para detectar contenido generado por IA con la velocidad y precisión necesarias para mitigar sus efectos más dañinos.

En tiempos de alta tensión, como unas elecciones, el peligro de este escenario es evidente. Como hemos visto en la región, las tensiones sociales durante los días decisivos de los comicios pueden verse exacerbadas por la manipulación de la información y la IA puede aumentar aún más esta tensión. El contenido generado por IA puede alimentar la controversia en torno a los resultados y la violencia política. Un gobierno electo puede ser presentado como ilegítimo o, en el peor de los casos, todo el sistema democrático verse desestabilizado. El intento de golpe de Estado en Brasil es un duro recordatorio de la vulnerabilidad del sistema cuando se utiliza la información como arma para socavar los resultados electorales.

Sin embargo, en su estado actual y sobre la base de las experiencias de 2024, la IA parece estar mejorando solo marginalmente la capacidad de los actores políticos para distorsionar el entorno informativo en torno a las elecciones. Su uso parece centrarse en incrementar la confusión y reforzar los discursos existentes, en un esfuerzo por erosionar la confianza en el sistema. Sin embargo, no es la fuerza motriz detrás de la creación de realidades alternativas. En cualquier caso, su influencia potencial es lo suficientemente significativa como para justificar un análisis. Finalmente, es imperativo establecer salvaguardas dentro del sistema para evitar sus consecuencias más perjudiciales.

Como ejemplifican los estudios de caso de Brasil y México, las elecciones de 2024 en la región y a nivel mundial solo han mostrado usos aislados y limitados de la tecnología, mientras que sigue habiendo un potencial sustancial para que la IA tenga un impacto más amplio en todo el ciclo electoral.

Dos razones principales explican lo limitado hasta ahora de esta influencia. En primer lugar, influir y alterar la capacidad de los ciudadanos para interpretar la realidad es un esfuerzo a largo plazo, y la IA generativa lleva disponible poco tiempo de forma amplia. En segundo lugar, la disrupción del ambiente informativo no es solo una cuestión de contenido. De hecho, tal vez el contenido en sí mismo sea el factor menos importante. Más importantes son la capacidad de difundir desinformación, los mecanismos de amplificación, la voluntad de los actores políticos de construir una realidad alternativa que no se base en hechos y, sobre todo, el fomento de grupos de personas dispuestas a abrazar esta realidad alternativa. Como se detallará más adelante, la distribución más amplia de Grok (a través de la plataforma de redes sociales X de Elon Musk) en Brasil ya ha comenzado a llenar de imágenes artificiales la política digital brasileña.

También debemos aceptar que es muy poco probable que seamos capaces de aislar de manera tajante el efecto de la IA en la integridad de la información. La forma en cómo se crea, comparte, difunde y consume la información es un proceso complejo. La IA puede influir en muchas fases diferentes de este proceso, alterándolas ligeramente y, por ello, modificando el resultado final de las elecciones. Sin embargo, en la mayoría de los casos, sería casi imposible establecer vínculos causales claros entre el uso de la IA y los cambios resultantes.

A pesar de ello, la IA no hará más que mejorar con el tiempo, al igual que debería hacerlo nuestra defensa de la democracia y las elecciones. Incluso si la influencia de la IA parece marginal hasta ahora, es solo cuestión de tiempo que se vuelva más significativa. La construcción de una realidad compartida y que se base en hechos debe ser fundamental para cualquier estrategia de protección de las elecciones. Las fuerzas democráticas deben entender que ciertos principios no son negociables, tales como: la aceptación de los resultados electorales, la garantía de la transferencia pacífica del poder, el respeto y la protección de las instituciones democráticas y la defensa del Estado de derecho. Fortaleciendo estos cimientos es como se defiende la democracia.

Este documento ahondará en el impacto potencial que la IA podría tener en la integridad de la información durante las elecciones, centrándose en tres aspectos diferentes. En primer lugar, se examinará la forma en cómo la IA impacta la creación y distribución de información. En el capítulo 1 se analizará cómo la IA generativa puede influir en la integridad de la información, explorando cómo está determinando el contenido al que tenemos acceso a través de la moderación, la curación y la distribución de dicho contenido, y las posibles consecuencias para grupos y colectivos marginados. El capítulo 2 ahondará en los casos de México y Brasil con un análisis detallado de los usos de la IA en las elecciones de estos países en 2024. En el capítulo 3 se explorarán las diferentes estrategias globales y regionales, analizando en qué medida toman en consideración e incluyen las elecciones y la democracia, al tiempo que se identifican las principales brechas. En el capítulo final se presentará un conjunto de recomendaciones de políticas para abordar los desafíos identificados.

El impacto de la IA en la integridad de la información ha sido ampliamente discutido en los últimos meses, especialmente por la coincidencia, en 2024, de una serie de elecciones importantes con un incremento aparentemente exponencial de la capacidad de las herramientas de IA generativa. Sin embargo, la mayoría de los temores de que una avalancha de información poco fiable inundara el entorno informativo y comprometiera la calidad de las elecciones parecen haber sido infundados, con un impacto observable mínimo en los resultados electorales.

La aparente falta de impacto podría explicarse por una combinación de factores, como la novedad de la IA, el hecho de que aún esté en desarrollo o los esfuerzos coordinados de la sociedad civil y algunas empresas tecnológicas para evitar su uso indebido. Un buen ejemplo de este esfuerzo coordinado es el Acuerdo Tecnológico para Combatir el Uso Engañoso de la IA en las Elecciones de 2024 [Tech Accord to Combat Deceptive Use of AI in 2024 Elections]: una iniciativa de algunas de las principales empresas tecnológicas con sede en Estados Unidos para limitar la influencia de la IA en las elecciones.

Se esperaba que la capacidad de la IA generativa para crear contenido manipulador tuviera una gran influencia en las elecciones, en parte al arrollar el ecosistema informativo con contenido manipulador que ahogase la información fiable.

Sin embargo, el aspecto clave de los contenidos manipuladores nunca fue su oferta, sino su demanda (Simon, Altay y Mercier, 2023). Hay dos razones por las que el tener la capacidad de crear una cantidad masiva de contenido manipulador no se traduce directamente en un aumento de la capacidad de manipular a los votantes. En primer lugar, la influencia es muy difícil de lograr, y las investigaciones apuntan a la existencia de un nivel mínimo de capacidad de información en línea para que se pueda modificar el comportamiento de los votantes (Coppock, Hill y Vavreck, 2020). Los contenidos en línea creados con el objetivo de manipular la creación de sentido colectivo pueden, a largo plazo, alterar las prioridades de la gente, pero su influencia depende menos de la cantidad de contenido que de su alcance (Rid, 2020). En segundo lugar, la demanda de contenido manipulador está altamente correlacionada con el bajo nivel de confianza en las instituciones y el partidismo fuerte (Simon, Altay y Mercier, 2023). Esto implica que el contenido manipulador se utiliza para confirmar los sesgos y las opiniones partidistas ya existentes, en lugar de transformar la percepción de los votantes.

Aunque la influencia actual de la IA sobre las elecciones pueda parecer limitada, esta percepción requiere matices y una visión a largo plazo. En primer lugar, la IA ya es una parte fundamental del ecosistema informativo y, como tal, influye en la forma en que se distribuye y amplifica la información. Las herramientas de IA se utilizan ampliamente para curar y jerarquizar contenidos, así como para moderarlos en todas las plataformas de redes sociales. Nuestros feeds están impulsados por IA, por lo que la información a la que tenemos acceso está determinada en gran medida por la IA. En segundo lugar, el perfeccionamiento exponencial de la tecnología en los últimos años apunta a que nuestra capacidad para detectarla, que ahora ya es baja, siga disminuyendo. Con aplicaciones de IA generativa mejores, más rápidas y precisas, los riesgos para la integridad de la información y la calidad de las elecciones aumentarán. En tercer lugar, la IA ya está mostrando un impacto sobre los colectivos tradicionalmente marginados, y especialmente sobre las mujeres políticas. Esto es cierto a nivel global y también para América Latina. En cuarto lugar, el análisis empírico del uso temprano de la IA generativa en las elecciones de todo el mundo muestra una diversidad de aplicaciones de la tecnología más allá de la manipulación política directa, como la producción de contenido político que apela al humor y las emociones.

Las siguientes secciones profundizarán en estos cuatro elementos, presentando un marco para la comprensión de las diferentes formas en que la IA podría afectar a la integridad de la información durante las elecciones a nivel global y en América Latina en un futuro cercano.

1.1. La IA y la creación y distribución de información en América Latina

La inteligencia artificial juega un papel fundamental en la distribución de contenidos electorales en línea. Aunque herramientas de IA generativa como ChatGPT, Gemini, Microsoft Copilot y otras son populares y conocidas, las empresas tecnológicas, en particular las plataformas de redes sociales, llevan utilizando la IA mucho tiempo. La IA es una herramienta importante para distribuir y difundir contenido en las plataformas de redes sociales a través de la curación y moderación automatizadas, incluso en América Latina. Los partidos políticos, los actores estatales, los políticos y las organizaciones de la sociedad civil utilizan las plataformas de redes sociales —y, por lo tanto, los sistemas de IA— para crear y difundir en línea contenido político relacionado con las elecciones.

Los procesos de diseño, desarrollo y despliegue de contenidos en las redes sociales no son neutrales. Por el contrario, están impulsados por incentivos políticos y económicos que dan forma a la esfera pública en línea, al entorno informativo y, en última instancia, a los procesos democráticos. Además, el marco legal institucional y el contexto geopolítico y sociopolítico también configuran el entorno de la información electoral. En consecuencia, el enfoque de las políticas conducentes a garantizar la integridad de la información electoral debe ser integral, teniendo en cuenta consideraciones políticas, culturales, sociológicas y geopolíticas, en lugar de centrarse únicamente en los ecosistemas de medios de comunicación o las plataformas de redes sociales. Este enfoque podría contribuir a iniciar un debate para la mejora de los valores democráticos en contextos de información electoral en línea.

Teniendo esto en cuenta, es importante destacar el impacto de los sistemas de IA en la integridad de la información en el contexto de los procesos electorales en América Latina. Por ello, en la siguiente sección se explicará cómo los sistemas de IA afectan a la integridad de la información en cuatro niveles: (a) creación de contenido; (b) curación de contenidos; (c) moderación de contenidos; y d) publicidad política en línea.

1.1.1. Creación de contenido

Las herramientas de IA generativa pueden producir contenido sofisticado a gran escala; contenido a menudo indistinguible del generado por humanos, y que atesora un potencial sin precedentes para el engaño (Juneja, 2024). En particular, la IA puede utilizarse para producir contenidos adaptados a los puntos de vista y opiniones de subconjuntos específicos de la población (Juneja, 2024). Contenidos tales como textos, elementos visuales o audios ya se han utilizado en campañas electorales en América Latina; en Argentina y Brasil, por ejemplo.

Las formas en que la IA generativa, especialmente los modelos extensos de lenguaje (LLM), pueden aumentar el alcance, el impacto y la influencia de las operaciones de información son abundantes. Es importante señalar, sin embargo, que aún no hemos sido testigos de todos los posibles efectos negativos de la tecnología en la integridad de la información durante las elecciones. Es probable que la IA generativa en general, y los LLM en particular, ejerzan principalmente un efecto multiplicador y amplificador. Este efecto tiene cuatro aspectos: a) reducción de las barreras de entrada; (b) aumento exponencial de la cantidad de contenido engañoso; c) hacer que los contenidos sean más adaptables y específicos; y (d) hacer que las operaciones de información sean más difíciles de detectar (Rid, 2020; Goldstein et al., 2023; Simon, Altay y Mercier, 2023).

La IA generativa reduce significativamente el coste y el esfuerzo para la realización de operaciones informativas, reduciendo las barreras de entrada y haciendo más accesibles dichas operaciones. Las herramientas de IA pueden incrementar en gran medida la eficiencia de las campañas políticas. Además, pueden facilitar la expansión de los proveedores de desinformación como servicio (DaaS), permitiendo que un mayor número de actores ingresen al mercado de DaaS (Soliman y Rinta-Kahila, 2024). Sin embargo, la capacidad de emplear tales tácticas no se traduce automáticamente en la intención de hacerlo. El aprovechamiento del material manipulador para influir en la opinión pública a través del engaño y las falsedades es una estrategia adoptada solo por ciertos partidos y candidatos (Törnberg y Chueri, 2025). Para muchos grupos políticos, el empleo de prácticas engañosas no es un enfoque atractivo. La mayoría de los partidos y candidatos que adoptan estas tácticas, ya sea directamente o a través de operadores DaaS, explotan la creciente desconfianza en el sistema político y la información oficial. Su objetivo es aprovechar esta disminución de la confianza en las instituciones democráticas para obtener ventajas políticas (Törnberg y Chueri, 2025).

La IA generativa permite a los partidos políticos y candidatos dispuestos a emplear tácticas manipuladoras producir material engañoso a una escala mucho mayor. Por ejemplo, los LLM pueden facilitar la creación de contenido falso para medios de comunicación en línea fabricados, una estrategia comúnmente utilizada en operaciones de información, incluso por parte de actores extranjeros (Rid, 2024). Un aumento en el contenido engañoso puede desvincular de la realidad a segmentos de la población, con respecto a temas críticos para el futuro político de América Latina tales como el cambio climático, la corrupción política o la migración (DiResta 2024). Además, puede hacer que la gente le sea cada vez más difícil acceder a información basada en hechos, necesaria para comprender el mundo con precisión.

De cualquier manera, el panorama de la información digital ya está inundado de contenido engañoso, lo que sugiere que solo un aumento de la demanda, en lugar de la oferta, convertiría la mayor capacidad de generar dicho material en una verdadera amenaza para la democracia (Simon, Altay y Mercier, 2023). Además, inundar el espacio informativo no equivale necesariamente a influencia. La desinformación afecta principalmente a aquellas personas que ya se inclinaban a creerla, en tanto refuerza sus percepciones preexistentes de la realidad (DiResta 2024). Factores como la desconfianza en las instituciones democráticas y la fuerte identificación partidista, sobre todo con los partidos de derecha radical, hacen que la gente sea más susceptibles a la adopción de relatos falsos (Grinberg et al., 2019; Törnberg y Chueri, 2025).

Un tercer impacto potencial de la IA generativa en la integridad de la información es su capacidad para la personalización extrema del contenido engañoso. Dichos contenidos pueden utilizarse para dañar a la gente, sobre todo mediante la creación de imágenes no consentidas, o para manipular sus percepciones. Una amenaza significativa planteada por la IA es el contenido pornográfico no consentido (para un análisis en profundidad, véase 1.2: La IA y las comunidades marginadas). Este tipo de contenido afecta de manera desproporcionada a las figuras políticas femeninas, actuando como una forma de violencia de género facilitada por la tecnología que limita aún más el espacio político disponible para las mujeres.

La IA generativa también aumenta la capacidad de adaptar y dirigir el contenido a grupos sociales específicos, lo que en teoría incrementa el poder persuasivo del contenido engañoso. Entre los métodos para adaptar y orientar el contenido está el uso de un lenguaje culturalmente apropiado, el empleo de referencias específicas, el encuadre de los problemas de una manera que cale en el grupo objetivo o la elaboración de contenido que manipule la realidad para atraer a grupos demográficos específicos. Si bien muchas operaciones de información dirigidas por extranjeros pueden detectarse debido a su uso antinatural del lenguaje o a la falta de conocimiento cultural, la IA generativa puede sortear estos escollos (Goldstein et al., 2023).

Incluso es técnicamente concebible que, en el futuro, las operaciones de información se vuelvan mucho más granulares, dirigiéndose a individuos con contenido engañoso adaptado a sus perfiles. Estas operaciones podrían aprovechar datos individualizados para generar materiales manipuladores, diseñados para influir o perjudicar a personas específicas. Hasta la fecha, sin embargo, los modelos de IA generativa no tienen acceso a datos personalizados que permitan este tipo de contenido.

En el caso de América Latina, la tecnología, en su forma actual, podría tener dificultades para dirigirse a la gente a un nivel tan granular. Los modelos de IA se entrenan a menudo con contenido creado originalmente en inglés y luego traducido automáticamente al español. En consecuencia, por un lado, los estudios han sugerido que estos modelos perpetúan prejuicios raciales, lo que podría impactar negativamente en el poder de persuasión del contenido (Hoffmann et al., 2024). Dado que están diseñados en inglés y funcionan mejor en contextos de habla inglesa, generan un desajuste entre los angloparlantes nativos y los usuarios de otros lugares, incluyendo América Latina (Nicholas y Bhatia, 2023), donde la falta de contexto local y datos en otros idiomas plantea un problema sistemático en la forma en que se utilizan estas tecnologías (Oversight Board, 2024).

Por último, la IA generativa podría mejorar la capacidad de las operaciones de información, sobre todo las realizadas por actores extranjeros, para evadir la detección (Goldstein et al., 2023). Las operaciones de influencia llevadas a cabo por potencias extranjeras fracasan a menudo debido a la falta de precisión en sus mensajes y el uso del lenguaje. Además, las empresas de redes sociales y algunas agencias estatales suelen tener la capacidad de identificar comportamientos inauténticos coordinados —típicos de este tipo de operaciones— y de detectar estas acciones antes de que puedan tener un efecto real (Rid, 2024). Sin embargo, la IA generativa puede dificultar la detección de operaciones de información mediante la creación de redes de identidades falsas en línea distribuidas de manera que se oculte su origen. Estas identidades pueden utilizarse para propagar discursos y forjar realidades alternativas, ya que pueden imitar mejor los dialectos locales, y el uso del idioma o incluso fingir acentos. También pueden saturar a las organizaciones de verificación de datos y dificultar grandemente su trabajo (Kahn, 2024).

1.1.2. Curación de contenidos

La IA se está utilizando, no solo para crear contenido en las plataformas de redes sociales, sino también para jerarquizar, promocionar o relegar contenido en las mismas, generalmente en función no solo de las preferencias y perfiles de los usuarios, sino también del uso de contenido diseñado para mantenerlos lo más enganchados posible, sin tener en cuenta ni su calidad ni su precisión (ARTICLE 19, 2021; OSCE, 2021; Narayanan, 2023). El objetivo principal de las herramientas impulsadas por IA, a menudo denominadas “algoritmos de clasificación” [ranking algorithms], es ayudar a las personas a encontrar contenido relevante en función de las consideraciones comerciales y, en algunos casos, políticas de las plataformas que utilizan. Dado el volumen, la escala y la velocidad a la que se propaga el contenido en las redes sociales, los sistemas de IA desempeñan un papel decisivo a la hora de priorizar y degradar el contenido en los feeds de los usuarios en función de sus perfiles y los modelos de negocio de las plataformas.

Estos avances pueden afectar a la precisión, la diversidad y el interés público del ecosistema informativo en los espacios en línea, lo que es especialmente sensible durante las elecciones (OSCE, 2021). Naciones Unidas (2018) también ha dicho que los usuarios pueden tener poca o ninguna exposición a ciertos tipos de contenido social o político crítico en sus plataformas. Esta falta de exposición podría socavar no solo la libertad de los ciudadanos de acceder a información diversa, sino también su derecho a formarse opiniones de manera independiente, libre de violencia, inducción o interferencia manipuladora de cualquier tipo (ACNUDH, 1996). Tales limitaciones al acceso a diversos contenidos podrían implicar una violación de otros derechos fundamentales, incluido el derecho a participar en los asuntos públicos.

En consecuencia, las herramientas impulsadas por IA que recomiendan contenido no son neutrales. La curación algorítmica viene determinada por los valores y objetivos del creador del algoritmo, así como por la dinámica sociotécnica, la autorregulación de la industria y la supervisión estatal (OSCE, 2021). Estos algoritmos se alimentan de un gran volumen de datos personales y de comportamiento, que se combinan con datos de terceros para crear perfiles sofisticados orientados a aumentar la participación y la retención de los usuarios, mediante la personalización de su experiencia.

La personalización del contenido también se utiliza en la publicidad y en las campañas políticas en línea. Se ha señalado que esta práctica puede implicar manipulación, polarización y fragmentación del debate político (Gorton, 2016). Además, varios estudios han demostrado que los algoritmos de curación o clasificación de contenidos contribuyen a la amplificación de la desinformación, el discurso de odio, los contenidos nocivos y la discriminación en las plataformas de redes sociales (Fundacja Panoptykon, 2023). El “contenido pronosticado más atractivo obtiene las puntuaciones más bajas en términos de calidad y confiabilidad” (Fundacja Panoptykon, 2023, pág. 3). La Fundación Mozilla (2021) también informó en un estudio que el 71 por ciento de las experiencias desagradables en YouTube planteadas por voluntarios habían sido recomendadas a los espectadores por la plataforma. Dado que es más probable que las personas hagan clic en contenido sensacionalista o incendiario, los algoritmos de clasificación privilegian el contenido dañino (Amnistía Internacional, 2019) en lugar de la información precisa, lo que socava la integridad electoral tanto en contextos online como offline.

En Brasil, durante el régimen de Bolsonaro—especialmente hasta las elecciones de 2022—se difundieron campañas de desinformación y teorías conspirativas en Twitter y WhatsApp, con el objetivo de desacreditar el voto electrónico y el proceso democrático del país (Souza, 2024). El proceso de radicalización iniciado en 2018, con la primera campaña presidencial de Jair Bolsonaro, y que culminó con el intento de golpe de Estado contra el presidente electo, Luiz Inácio Lula da Silva en 2022, muestra el impacto que puede tener la desinformación.

Por otro lado, las herramientas de curación de contenidos impulsadas por IA se entrenan con datos que no reflejan realidades contextuales, históricas y económicas más amplias. Por lo tanto, es posible que aparezcan sesgos en la forma en que se distribuye el contenido, distorsionando, minimizando o amplificando ciertos mensajes para involucrar a los ciudadanos en las plataformas de redes sociales.

Debido al volumen de datos procesados por las herramientas impulsadas por IA, los algoritmos de clasificación deben examinarse en dos niveles. En primer lugar, los datos que se recopilan para entrenarlos deben divulgarse y categorizarse claramente. En segundo lugar, los algoritmos de clasificación deben explicar el razonamiento que hay detrás de su producción (por qué se muestra cierto contenido a un usuario en particular) y qué puntos de datos llevaron a la decisión de mostrar ese contenido.

El diseño de incentivos que promuevan los valores democráticos, como la pluralidad de los medios de comunicación así como la diversidad de opiniones, y la restricción de los datos utilizados para entrenar los algoritmos, podrían mitigar los efectos negativos de la curación de contenidos. Proporcionar acceso a los datos y permitir auditorías de algoritmos por parte de terceros podría ayudar a reducir los resultados inesperados y problemáticos de estas herramientas impulsadas por IA.

1.1.3. Moderación de contenidos

La moderación de contenido implica a menudo la externalización a gran escala combinada con la detección automatizada de aprendizaje automático [machine learning]. Los sistemas de IA ayudan a las empresas de redes sociales a identificar, combinar, predecir o clasificar el contenido generado por el usuario en función de sus características para determinar qué debe permanecer en línea y qué debe eliminarse. Este proceso suele darse después de que los usuarios publican contenido en una plataforma de redes sociales. En otras palabras, las herramientas de moderación de contenidos actúan como guardianes, guiándose por las políticas y el modelo de negocio de la plataforma, así como por el marco jurídico nacional en el que la plataforma opera.

Las herramientas de moderación de contenido pueden desempeñar las siguientes funciones:

- detectar contenidos que infrinjan la ley (por ejemplo, incitación al odio o difusión de imágenes íntimas sin consentimiento) o las políticas internas de la plataforma;

- identificar las infracciones evaluando si el contenido detectado infringe las políticas internas; y

- hacer cumplir las políticas marcando o eliminando el contenido en línea creado por los usuarios, en función de las directrices de la plataforma (OSCE, 2021).

Las plataformas emplean a menudo prácticas como la despriorización y la desjerarquización para minimizar la visibilidad de contenido dañino o ilegal.1 La suspensión y eliminación de cuentas también es parte integral de estos procesos de moderación de contenido.

Los sistemas de IA facilitan estos procesos al revisar, tomar decisiones y restringir la información o la desinformación a gran escala, a menudo sin intervención humana. La automatización de estos procesos puede mejorar la coherencia y la previsibilidad. Gracias al procesamiento del lenguaje natural, las técnicas de moderación de contenidos pueden identificar emociones positivas y negativas, clasificándolas como “ofensivas” o “no ofensivas”.

Sin embargo, el uso de la IA en la moderación de contenidos también comporta riesgos. El etiquetado incorrecto puede dar lugar tanto a falsos positivos, con contenido legítimo etiquetado erróneamente como ilegal o perjudicial, como a falsos negativos, con contenido ilegal o perjudicial pasando desapercibido.

Los desafíos antes mencionados se ven agravados por los sesgos en los datos de entrenamiento utilizados para los sistemas de IA, que a menudo se basan en contenido escrito principalmente en inglés. Esta dependencia del contenido en inglés crea dificultades para detectar la desinformación o el discurso de odio en contextos no ingleses. Por ejemplo, para el caso del quechua, una lengua indígena hablada en América Latina, se ha informado de que el “mayor obstáculo para abordar los daños en línea es la ‘falta de datos digitales de alta calidad’” (Shahid, 2024). Además, los “Facebook Papers” revelaron que el 87 por ciento del gasto global de Facebook en clasificar desinformación se dirigió al contenido en inglés, a pesar de que solo el 9 por ciento de sus usuarios son hablantes nativos de ese idioma (Elswah, 2024).

1.1.4. Publicidad política en línea

Las plataformas en línea dependen de la publicidad en línea, incluida la publicidad política online, para monetizar sus servicios. La publicidad está en el centro de los modelos de negocio de las plataformas de redes sociales porque les permite monetizar la atención y la retención de los usuarios. En este contexto, los sistemas de IA se utilizan para desplegar y distribuir publicidad política en las plataformas de redes sociales.

Por un lado, las técnicas de microsegmentación (segmentación de anuncios) permiten a partidos políticos y activistas identificar y dirigirse a segmentos específicos del electorado con anuncios políticos personalizados de alta granularidad. Es posible, por ejemplo, presentar un anuncio político particular a mujeres jóvenes que viven en Santiago de Chile, de 18 a 24 años, a quienes les gusta la música K-pop, se inclinan políticamente hacia la izquierda y se interesan por la naturaleza y los deportes. Un anuncio distinto, con un mensaje completamente diferente, podría mostrarse a otro grupo demográfico específico. Estas técnicas de segmentación se basan en diferentes fuentes de datos, incluidos los datos personales y de comportamiento, los datos generados por las propias plataformas de redes sociales y los datos de terceros. En conjunto, estos datos se utilizan para crear perfiles altamente personalizados que determinan qué contenido se amplifica en el timeline de un usuario en particular y qué anuncios se muestran al usuario (Ali et al., 2019).

Por otro lado, las plataformas de redes sociales utilizan técnicas de amplificación para entregar anuncios políticos a los destinatarios más relevantes (European Parntership for Democracy, s.f.). Este proceso, conocido como ad delivery [entrega de anuncios], implica que la plataforma muestre anuncios a los usuarios en función de algoritmos de aprendizaje automático. Estos algoritmos procesan datos de comportamiento como los likes, los posts compartidos, las conexiones, los clics y las visualizaciones de video para crear perfiles completos de usuario en línea. Con estos datos, los sistemas de IA pueden predecir los comportamientos de los usuarios, revelando características sensibles como la inclinación política, las creencias religiosas, las condiciones de salud, etcétera. Sin embargo, debido a que algunos usuarios son considerados más valiosos que otros, este proceso puede tener consecuencias discriminatorias en la distribución de anuncios políticos (Ali et al., 2019).

Además, estas técnicas ayudan a afinar los algoritmos de clasificación para mantener a los usuarios enganchados al contenido, lo que puede reforzar los sesgos y alimentar las opiniones radicales. Al difundir desinformación y mala información, contribuyen a la creación de cámaras de eco, que pueden fragmentar la esfera pública en línea. Esta fragmentación facilita la manipulación, la polarización y la radicalización de la ciudadanía.

1.2. La IA y los grupos marginalizados

Al igual que ocurre con la mayoría de los desafíos sociales, los grupos marginados sienten el impacto de esta cuestión de manera más aguda que el resto de la población. En América Latina, eso incluye colectivos de clase trabajadora, mujeres, personas LGBTQIA+, personas con discapacidad y grupos indígenas. Los grupos marginados se enfrentan a riesgos cada vez mayores, incluso en los espacios digitales, que pueden verse agravados por sistemas de IA diseñados, implementados o regulados sin la debida consideración de los derechos humanos y los valores democráticos.

Uno de los ejemplos más claros de las consecuencias potencialmente negativas de la IA es su capacidad para perpetuar y amplificar la discriminación y el acoso por motivos de género en los entornos en línea. La IA generativa, por ejemplo, se ha utilizado como arma en todo el mundo para crear contenido deepfake, incluido material explícito no consensuado, que se dirige de manera desproporcionada a las mujeres y las minorías sexuales (Burgess, 2021). Numerosos sitios web ofrecen servicios de deepfake, lo que supone una amenaza tangible para las mujeres, que a menudo son objeto de contenidos pornográficos generados por IA. Las aplicaciones permiten a los usuarios subir fotos y generar imágenes de desnudos realistas de personas sin su consentimiento. En México, por ejemplo, un estudiante universitario transformó 166.000 fotos de compañeros de clase en material pornográfico y las vendió en Telegram (Rodríguez, 2023).

Estas prácticas no se limitan a la explotación personal, sino que también se utilizan indebidamente para debilitar a las candidatas políticas. En las recientes elecciones municipales de 2024 en Brasil, por ejemplo, se empleó tecnología deepfake para dirigirse a candidatas políticas, representando a mujeres en escenarios comprometedores o explícitos, con el objetivo de dañar su reputación y sus perspectivas electorales (Farrugia, 2024). Si bien los políticos masculinos también son blanco de los deepfakes, a menudo por sus declaraciones o acciones políticas, estos ataques les permiten generalmente preservar un sentido de integridad personal. Por el contrario, los ataques deepfake contra mujeres políticas tienden a girar en torno a conductas personales indebidas, que alimentan la cosificación, refuerzan estereotipos dañinos y minan la credibilidad de dichas mujeres (Cerdán Martínez y Padilla Castillo, 2019). El uso lesivo de la tecnología deepfake no solo compromete la dignidad de las mujeres, sino que también puede disuadirlas de presentarse a las elecciones o de participar plenamente en el proceso electoral (Souza y Varon, 2019; Fundación Multitudes, 2023; Ríos Tobar, 2024), con repercusiones sobre su bienestar mental, seguridad personal y representación política en general.

Varios países latinoamericanos han comenzado a adoptar enfoques de género en las políticas de ciberseguridad, abordando problemas como el ciberacoso y el intercambio no consentido de imágenes íntimas (González-Véliz y Cuzcano-Chávez, 2024). Las elecciones municipales de Brasil de octubre de 2024 se celebraron bajo una nueva y estricta normativa electoral que prohibía el uso de contenidos generados por IA no etiquetados en las campañas, en un esfuerzo por frenar la desinformación impulsada por estas tecnologías. Aunque es probable que estas medidas reduzcan algunos riesgos, la regulación por sí sola no es suficiente para prevenir por completo la propagación de deepfakes dañinos y violentos. Del mismo modo, la Ley Olimpia de México de 2020 penaliza la difusión no consentida de contenidos sexuales, aunque su alcance sigue siendo demasiado limitado para abordar plenamente los delitos específicos de la tecnología deepfake (Piña, 2023).

Además, las plataformas de redes sociales que dependen de la IA para la moderación de contenidos suelen quedarse cortas a la hora de proteger a los grupos marginados. Por ejemplo, las investigaciones muestran que la moderación de contenidos impulsada por la IA en las plataformas de redes sociales suele tener dificultades para identificar y eliminar eficazmente el discurso de odio dirigido contra grupos marginados, a menudo debido a la naturaleza matizada y específica del contexto de dichos contenidos (Udupa, Maronikolakis, Schütze y Wisiorek, 2023). Por el contrario, los sistemas de IA señalan a veces el activismo o los debates legítimos sobre cuestiones de género y LGBTQIA+ como violaciones de las políticas de las plataformas, silenciando las voces críticas y limitando su alcance.

Las comunidades indígenas suelen ser particularmente vulnerables a la manipulación de los entornos de información electoral. Se enfrentan a una serie de desafíos, como las campañas de desinformación, la manipulación e injerencia de la información extranjera, la exclusión sistemática de los espacios digitales y la amplificación de los discursos de odio por medio de las tecnologías emergentes. Con frecuencia, estas campañas explotan estereotipos culturales o tergiversan las tradiciones y demandas políticas indígenas, lo que socava la credibilidad de los líderes, activistas y movimientos indígenas (Aaberg, Gurung, Kandie, Méndez y Xón, 2024).

Durante los períodos electorales en Bolivia, por ejemplo, la desinformación, el discurso de odio y los discursos cargados de racismo han circulado deliberadamente para deslegitimar la participación indígena en la política (Wood, 2019). Tales tácticas no solo distorsionan el discurso público, sino que también incitan al odio, el racismo y los prejuicios contra los pueblos indígenas, erosionando efectivamente su importancia y contribuciones tanto a nivel nacional como mundial. Los informes han documentado el uso de información engañosa para fomentar la intolerancia, profundizando así los agravios históricos y las injusticias sistemáticas contra las comunidades indígenas (The Carter Center, 2021; Funk, Shahbaz y Vesteinsson, s.f.).

Las tecnologías de IA han exacerbado la vulnerabilidad de las comunidades indígenas. Las herramientas automatizadas de generación de contenidos, las redes de bots a gran escala y la segmentación algorítmica sofisticada pueden incrementar en gran medida la propagación, la personalización y la persistencia de la desinformación y el discurso de odio (Funk, Shahbaz y Vesteinsson, s.f.). Como resultado de ello, los líderes y movimientos indígenas pueden encontrarse con una desventaja aún mayor, luchando por contrarrestar los discursos que se difunden amplia y persistentemente a través de las plataformas digitales.

Los sesgos algorítmicos intensifican las formas existentes de exclusión, especialmente cuando los sistemas de IA se entrenan con conjuntos de datos que no representan adecuadamente a las comunidades indígenas. Como resultado, estas tecnologías refuerzan estereotipos dañinos y no satisfacen las necesidades específicas de las poblaciones indígenas. Las deficiencias metodológicas, como la generalización excesiva o la falta de adaptación de los modelos a los contextos locales, pueden distorsionar la realidad. Al hacerlo, los algoritmos sesgados no solo tergiversan la verdad, sino que también amplifican las desigualdades existentes, ensanchando así la brecha digital a la que se enfrentan las comunidades indígenas (Naciones Unidas en México, 2023).

Antes de plantearse el uso de la IA en procesos públicos como las elecciones, hay que abordar la cuestión fundamental del acceso. En toda América Latina y el Caribe, las comunidades indígenas se enfrentan a una brecha digital étnica pronunciada, ya que la infraestructura y la conectividad atienden principalmente a las zonas urbanas. Este desequilibrio deja a muchos pueblos indígenas de las regiones rurales con oportunidades limitadas para acceder a las herramientas digitales. Para agravar este desafío, las brechas generalizadas en la alfabetización digital restringen aún más su capacidad para participar plenamente en el ecosistema digital. Según la Comisión Económica para América Latina y el Caribe de las Naciones Unidas, mientras que el 40 por ciento de la población de la región tiene conocimientos básicos de informática, menos del 30 por ciento puede usar hojas de cálculo de manera efectiva, menos del 25 por ciento puede instalar nuevos dispositivos o software y solo alrededor del 7 por ciento tiene experiencia en programación (Naciones Unidas en México, 2023).

Estas desigualdades sistemáticas perpetúan la exclusión de las perspectivas indígenas del desarrollo de la IA. La conectividad limitada, las políticas insuficientes y las competencias técnicas inadecuadas refuerzan un ciclo de marginación que disminuye el conocimiento y las experiencias indígenas. Construir una IA ética e inclusiva exige que cerremos las brechas de conectividad y habilidades, corrijamos los sesgos algorítmicos, defendamos la soberanía de los datos indígenas e integremos diversas visiones del mundo. Un primer paso crucial es reconocer a los pueblos indígenas no solo como participantes, sino también como creadores e innovadores dentro de los marcos tecnológicos.

Estos son solo algunos de los desafíos que ilustran la intrincada superposición entre la integridad de la información, la IA y la integridad electoral, en particular su impacto desproporcionado sobre los grupos marginados de la sociedad. Este documento busca explorar el papel de la IA en estos procesos electorales y desarrollar recomendaciones específicas para que las empresas de redes sociales, los responsables políticos y las autoridades regulen de manera eficaz los sistemas de IA. Dichas regulaciones deben abordar la creación, la curación y la moderación de contenidos en línea, dando prioridad a los derechos humanos y los principios democráticos.

Para comprender cómo la inteligencia artificial ha influido en los procesos electorales en América Latina, este capítulo investigará cómo se utilizaron las herramientas impulsadas por IA en las elecciones de 2024 en México y Brasil. Para este análisis, nos basamos en informes elaborados por FGV Comunicação Rio (2024) sobre el uso de la inteligencia artificial generativa en elecciones en todo el mundo en 2024, en artículos publicados en sitios web de noticias brasileños y mexicanos y en el monitoreo continuo del debate público realizado por DappLab (FGV DAPP, 2017), el laboratorio de monitoreo de redes sociales FGV Comunicação Rio.

Las elecciones que tuvieron lugar en México el 2 de junio de 2024 estuvieron entre las más grandes de la historia del país, con 92 millones de votantes habilitados y una participación final de más del 60 por ciento (INE, 2024a). Los comicios se llevaron a cabo a través del voto directo y obligatorio, utilizando boletas de papel, participaron siete partidos políticos y más de 20.000 cargos electos, incluidos diputados, senadores, el presidente, gobernadores estatales, autoridades locales y un nuevo alcalde de Ciudad de México, la capital del país. Operando bajo un sistema presidencial republicano, el parlamento nacional es bicameral, compuesto por una cámara con 500 diputados y otra con 128 senadores.

Tres candidatos se disputaron principalmente la carrera presidencial: Claudia Sheinbaum, en representación de la coalición gobernante de izquierda Sigamos Haciendo Historia, que ganó con el 59,3 por ciento de los votos válidos; Xóchitl Gálvez, de la alianza opositora Fuerza y Corazón, que obtuvo el 27,9 por ciento de los votos válidos; y Jorge Álvarez Máynez, del Movimiento Ciudadano, que obtuvo el 10,4 por ciento de los votos válidos (INE, 2024a).

Las elecciones de 2024 marcaron un hito para la representación de las mujeres en la política mexicana, ya que se eligieron cuatro gobernadoras y la primera mujer presidenta del país (Martínez Holguín, 2024)

Como sucesora del presidente Andrés Manuel López Obrador, Sheinbaum encabezó constantemente las encuestas, enfrentándose a críticas similares a las dirigidas a López Obrador, sobre todo en lo que respecta a la supuesta indulgencia del gobierno de izquierda de México hacia los cárteles de la droga. En este contexto, la violencia y la delincuencia dominaron la preocupación pública, convirtiéndose en temas centrales de los debates políticos, particularmente en relación con la alta tasa de homicidios del país, la violencia política de género, las disputas entre cárteles y los incidentes de violencia política. A pesar de estos problemas, los temas relacionados con la economía y la salud también adquirieron protagonismo, mientras que las políticas migratorias se discutieron de manera más marginal (Associated Press, 2024).

Al mismo tiempo, la desinformación siguió siendo un problema persistente antes de las elecciones. A lo largo del período electoral circularon rumores de fraude electoral, una propuesta de nueva constitución, la abolición de la propiedad privada e incluso afirmaciones de que Sheinbaum tenía la intención de cerrar la basílica de Nuestra Señora de Guadalupe. Los informes locales también destacan la difusión de información falsa, incluidos los vínculos inventados entre López Obrador, Sheinbaum y el narcotráfico, así como las acusaciones de que la esposa de López Obrador tenía conexiones con el nazismo.

En este contexto, las elecciones mexicanas también sirvieron de telón de fondo para el uso de la IA generativa en las campañas políticas y la información, no solo para difundir deepfakes para desacreditar a los candidatos o difundir desinformación política, sino también para las estafas financieras que explotaban la imagen de los candidatos.

Brasil celebró elecciones municipales en octubre de 2024, en las que se eligieron alcaldes, vicealcaldes y representantes legislativos en 5.569 municipios. Si bien las elecciones municipales en el país tienen una tradición de menor polarización y reciben menos recursos que las nacionales, las elecciones de 2024 se llevaron a cabo en un ambiente político muy cargado. Las contiendas en varias ciudades clave, entre ellas São Paulo y Fortaleza, fueron particularmente intensas, con candidatos a la alcaldía alineados estrechamente con figuras políticas nacionales como el presidente Luiz Inácio Lula da Silva y el expresidente Jair Bolsonaro, quien, a pesar de no ser elegible para ocupar cargos públicos, sigue siendo una figura central de la oposición. Estas elecciones locales fueron ampliamente vistas como un preludio estratégico para las elecciones generales de 2026, forjando alianzas y discursos para la próxima carrera presidencial.

Las elecciones se celebraron en medio de una creciente preocupación por el papel de las plataformas digitales en la democracia brasileña. Dada la anticipación en torno a la posible influencia de la IA sobre las campañas políticas, la principal autoridad electoral de Brasil, el Tribunal Superior Electoral, emitió nuevas regulaciones antes de las elecciones para frenar la desinformación y el uso indebido de contenido generado por IA (TSE, 2024). Estas medidas incluían el etiquetado obligatorio de contenido sintético en los anuncios políticos y una supervisión más estricta de las campañas digitales.

Contrariamente a lo esperado, la IA no se utilizó tan ampliamente como se temía en principio. Al igual que en México, gran parte del uso observado de la IA durante el periodo electoral se vio eclipsado por una serie de acontecimientos que, si bien se vinculaban al uso de Internet en la política, no estaban relacionados directamente con la inteligencia artificial. Estos eventos y los casos documentados de uso de la IA revelan una relación compleja entre la innovación y los desafíos de larga data en la comunicación política brasileña. Incluso en esta etapa temprana, las características de estas aplicaciones de IA son notables.

2.1. Uso de la inteligencia artificial generativa en las elecciones nacionales y locales

En México, el uso de la inteligencia artificial sigue siendo considerado un tema periférico en comparación con problemas más acuciantes, como la violencia política y el narcotráfico. Aunque no ha habido muchos casos que hayan tenido repercusiones significativas para las plataformas digitales, la difusión de deepfakes y otras aplicaciones de IA está vinculada a problemáticas nacionales, particularmente en el contexto electoral, donde estas tecnologías se han utilizado de manera constructiva tanto como herramientas para la desinformación y la manipulación (Del Pozo y Arroyo, 2024).

En estas elecciones que dieron como resultado la primera mujer presidenta del país, la desinformación reflejó problemas políticos de larga data en México. Los usos potencialmente dañinos de la IA, especialmente los deepfakes, también siguieron esta tendencia, atrayendo una mayor atención dentro del panorama electoral mexicano. Ejemplos notables incluyen videos manipulados del presidente López Obrador, en los que promovía presuntamente esquemas de inversión fraudulentos, como acciones de Pemex o aplicaciones financieras falsamente atribuidas a Elon Musk. Este material incluso fue verificado por Reuters tras ser compartido más de 2.000 veces en Facebook (El Economista, 2024).

Es interesante observar que, incluso en el contexto electoral, se ha prestado mucha atención a las falsificaciones dirigidas contra los sectores económico y financiero, y no tanta a las directamente relacionadas con las elecciones. En otras palabras, el contenido fraudulento utilizaba imágenes de figuras políticas, pero no mencionaba específicamente las elecciones.

Antes de ser elegida presidenta, Sheinbaum también fue objeto de contenido manipulado que la vinculaba con esquemas de inversión fraudulentos, mientras los deepfakes regionales ganaban protagonismo en las disputas locales. En Tijuana, se utilizaron grabaciones de audio atribuidas a figuras políticas para influir en las campañas, y en el estado de San Luis Potosí, Enrique Galindo Ceballos, candidato a la alcaldía, denunció el uso de la IA para lanzar ataques contra su candidatura, lo que llevó a una denuncia formal ante el Instituto Nacional Electoral (Flores Saviaga y Savage, 2024).

A nivel nacional, los deepfakes apuntaban a los principales candidatos presidenciales. Sheinbaum, por ejemplo, fue representada en videos manipulados con símbolos comunistas de fondo mientras hablaba en ruso, mientras que Gálvez apareció sosteniendo una bandera nacional con un emblema invertido (Flores Saviaga y Savage, 2024).

El uso de la IA también se observó en las elecciones locales de México, con la Fundación Friedrich Naumann y el Consejo Alemán de Relaciones Exteriores (Del Pozo y Arroyo, 2024) identificando 44 casos de este tipo. Un ejemplo destacado fue un clip de audio supuestamente proveniente de una conversación entre Montserrat Caballero, alcaldesa de Tijuana, y Maricarmen Flores, entonces candidata por el Partido Acción Nacional, discutiendo temas de campaña (Del Pozo y Arroyo, 2024).

Otros usos de la IA revelan cómo las figuras políticas pueden aprovechar la tecnología para protegerse de las acusaciones, alegando haber sido víctimas de contenido fabricado, incluso cuando tales afirmaciones seguían sin probarse. En las elecciones mexicanas, Martí Batres, candidato a la presidencia, afirmó que una grabación de audio que circulaba en redes sociales en la que discutía el proceso interno de selección de candidatos del partido Morena había sido generada por inteligencia artificial. A pesar de su defensa, los expertos dijeron a los periódicos mexicanos en ese momento que era imposible determinar si la grabación era válida o generada por IA (Murphy, 2024).

En las elecciones brasileñas también se observaron casos similares de grabaciones de audio de autenticidad discutida, con los propios candidatos impugnando su validez. Sin embargo, muchos de estos casos no fueron confirmados o fueron desestimados por el Tribunal Electoral del país debido a la falta de pruebas o de las herramientas técnicas necesarias para verificar la autenticidad de las grabaciones (Murphy, 2024).

El caso más notable ocurrió en la segunda vuelta de las elecciones brasileñas, cuando el candidato a la alcaldía de Fortaleza, André Fernandes, acusó a su oponente Evandro Leitão y a su equipo de crear una grabación de audio supuestamente falsa en la que Fernandes parecía respaldar el soborno y la compra de votos. Fernandes hizo la acusación en Instagram, convocó una conferencia de prensa y presentó las pruebas ante el Tribunal Electoral. Al igual que en el caso de Batres, los medios de comunicación consultaron a expertos para verificar la autenticidad de la afirmación, pero no pudieron determinar si el audio era realmente falso.

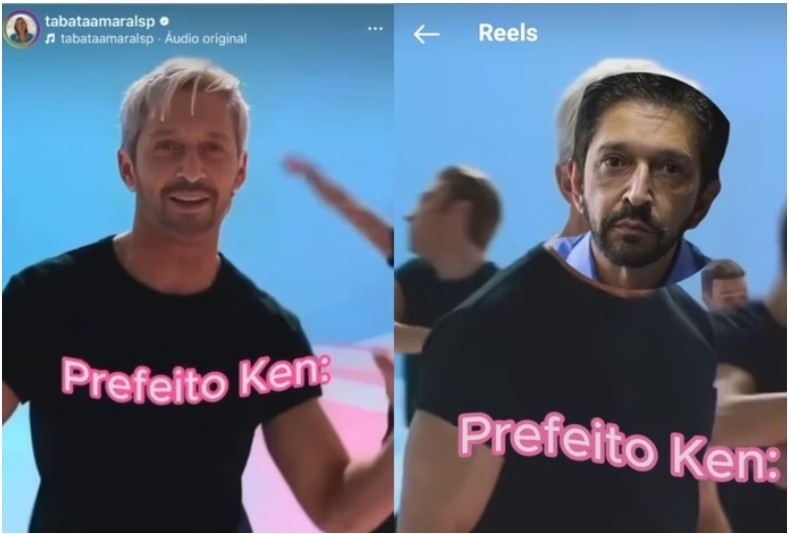

Otro uso de herramientas de IA generativa observado en las elecciones analizadas fue la difusión de cheapfakes, es decir, manipulaciones sencillas y de bajo coste de imágenes y vídeos, como cortes de edición, cambios de velocidad o recontextualización. A diferencia de los deepfakes, que utilizan IA avanzada para crear falsificaciones realistas, los cheapfakes se basan en ediciones básicas que el público general puede hacer.

Uno de los ejemplos más representativos de esta técnica en las elecciones brasileñas ocurrió en abril de 2024, antes del periodo oficial de campaña para las elecciones municipales. En ese momento, Tabata Amaral, precandidata a la alcaldía de São Paulo, se burló del entonces alcalde, Ricardo Nunes, después de que se refiriera a ella como la “Barbie de la política”. En respuesta, Amaral publicó un video de la película de Barbie con la cara de Nunes superpuesta al personaje de Ken. El partido de Nunes, el Movimiento Democrático Brasileño, presentó una denuncia ante el Tribunal Electoral, alegando que el uso de la IA estaba prohibido y acusando a Amaral de hacer campaña prematura. En respuesta, la diputada eliminó el video y publicó una nueva versión, cambiando de una edición de estilo deepfake a una estética de collage más amateur (Resk, 2024).

Se observaron ejemplos similares durante las elecciones, en videos compartidos tanto por los propios candidatos como por sus partidarios. En estos casos, los candidatos y otras figuras políticas prominentes se veían colocados en situaciones inusuales y vergonzosas. Estos ejemplos hablan de una forma distintiva de participación política en Brasil, donde el humor y la crítica son expresiones populares de compromiso político entre los ciudadanos.

Estos casos provocaron un debate sobre los desafíos de la aplicación uniforme de las políticas. Aunque la Resolución 23.732, emitida por el Tribunal Superior Electoral de Brasil en 2024, establece reglas claras para el uso de la IA en la propaganda electoral (TSE, 2024), un estudio del Laboratorio de Gobernanza y Regulación de la Inteligencia Artificial (Laboratório de Governança e Regulação de Inteligência Artificial), vinculado al Instituto Brasileño de Educación, Desarrollo e Investigación (Instituto Brasileiro de Ensino, Desenvolvimento e Pesquisa), concluyó que las sentencias de los tribunales locales de todo el país carecían de coherencia en la clasificación de los deepfakes a pesar de la claridad de la resolución. Por ejemplo, la denuncia del Movimiento Democrático Brasileño en relación con el video de Ken (mencionado anteriormente) fue finalmente desestimada por el tribunal electoral de São Paulo, que dictaminó que carecía de intención ilícita y entraba en el ámbito de la libertad de expresión. Sin embargo, otros tribunales de todo el país adoptaron un enfoque más estricto, prohibiendo cualquier uso de deepfakes, incluso cuando estaban etiquetados o eran claramente identificables (Caballero et al., 2024).

2.2. La IA como amplificador de la violencia política de género

Aunque México eligió por primera vez a una mujer presidenta, lo cual representa un avance en la representación política de las mujeres, en las elecciones de 2024 también se registró un aumento significativo de la violencia política de género. Datos del Instituto Nacional Electoral indican que durante el período electoral se registraron 205 denuncias relacionadas con este tipo de violencia, de las cuales el 42 % correspondieron a ataques en redes sociales. La violencia incrementó su frecuencia y gravedad a medida que se acercaba el día de las elecciones, pasando de los formularios digitales a las amenazas físicas, las agresiones e incluso los asesinatos (Rangel, 2024).

Uno de los casos más destacados fue el de la senadora del estado de Chihuahua Andrea Chávez, que denunció en las redes sociales la distribución de una imagen manipulada por IA que mostraba su rostro en el cuerpo semidesnudo de otra persona. Un informe de la Fundación Friedrich Naumann y del Consejo Alemán de Relaciones Exteriores (Del Pozo y Arroyo, 2024) también menciona casos en los que se utilizó la IA para “embellecer” a las candidatas. Si bien dicha manipulación de imágenes no constituye necesariamente violencia política de género, refuerza los estereotipos de la cosificación femenina en posiciones de poder y también representa un desafío para la aplicación de las leyes nacionales de México con respecto a la tecnología y la violencia digital de género. Como se ha mencionado anteriormente en este informe, si bien la llamada Ley Olimpia se diseñó principalmente para abordar la distribución no consentida de imágenes íntimas, los debates recientes sobre la ley han tomado en consideración su posible aplicación a contenidos generados por IA, como los desnudos deepfake (Borchardt, 2024)

Más allá de la exposición, el ridículo y la vergüenza asociada a este tipo de ataques, estos casos también causan daños materiales a los afectados, que se ven obligados a dedicar tiempo y esfuerzo a denunciar los incidentes, encausar a los responsables o hacer que se elimine el contenido. Durante las campañas electorales, el tiempo y el esfuerzo dedicados a combatir los deepfakes también pueden perjudicar las posibilidades electorales de un candidato. Si bien los políticos varones también son víctimas de ataques y burlas generados por la IA, se detecta un claro patrón de género cuando se examinan los casos que involucran a mujeres, generalmente con el objetivo de avergonzarlas y silenciarlas mediante la activación de estereotipos, relacionados sobre todo con la sexualidad.

2.3. Herramientas para la promoción de la ciudadanía

A pesar de los desafíos que plantea la inteligencia artificial en contextos electorales, las elecciones de Brasil y México también demostraron la posibilidad de aplicar esta tecnología al fortalecimiento de la democracia y la participación ciudadana. Un claro ejemplo de ello fue el uso de chatbots y otros recursos generados por IA para fomentar una interacción más estrecha entre candidatos y votantes.

Aunque no es algo exclusivo de las elecciones de 2024 en América Latina, las elecciones municipales de Brasil proporcionaron un ejemplo positivo de cómo se pueden aprovechar los chatbots para mejorar la comunicación política y la participación de los votantes. Su despliegue fue particularmente notable entre los candidatos a la alcaldía de las principales capitales brasileñas, que utilizaron herramientas impulsadas por IA para interactuar con los votantes, presentar propuestas y movilizar partidarios para eventos de campaña. El uso de chatbots en las elecciones de 2024 en Brasil estaba regulado por el Tribunal Superior Electoral, que ordenó que los candidatos no pudieran simular personas reales y se indicara claramente que las interacciones estaban impulsadas por IA (Tribunal Superior Eleitoral, 2024).

Incluso dentro de los límites impuestos por las normas electorales, estas herramientas tienen un potencial significativo para agregar valor a la imagen de un candidato. Al automatizar las interacciones y proporcionar información a los votantes, estos asistentes virtuales no solo ampliaron el alcance de la campaña, sino que también activaron elementos culturales y simbólicos, influyendo en la percepción pública de los candidatos.

En México, casos similares demostraron el potencial positivo de la IA. Durante la precampaña, Xóchitl Gálvez utilizó la IA generativa para crear una versión digital de sí misma, llamada iXóchitl y comunicarse con los votantes en videos de campaña en las redes sociales. Gálvez también afirmó que utilizó herramientas de IA para prepararse para los debates electorales, simulando preguntas de su oponente (Ormerod, 2023).

El Instituto Nacional de Elecciones (INE) también desplegó herramientas de IA durante las elecciones mexicanas para ayudar a combatir la desinformación, lanzando el chatbot Inés como una herramienta para que los usuarios denunciaran contenidos potencialmente engañosos y que estos fueran verificados por empresas especializadas (INE, 2024b).

Las agencias gubernamentales responsables de supervisar el proceso electoral de Brasil también adoptaron chatbots impulsados por IA. En el estado de Bahía, el Tribunal Electoral utilizó el chatbot Maia, que brindó apoyo a través de WhatsApp y Telegram para la presentación de informes financieros de campañas y facilitó el acceso de los ciudadanos a la información relacionada con las elecciones, promoviendo una mayor transparencia y accesibilidad. En Pernambuco, otro estado brasileño, el asistente virtual Júlia permitió a los votantes acceder a información relacionada con las elecciones a través de Telegram, incluida la verificación de su estado de registro de votante, la obtención de su número de identificación de votante, la búsqueda de su lugar de votación y el acceso a orientación sobre la seguridad electoral y las regulaciones de campaña (Tribunal Regional Eleitoral–BA, 2024).

El uso de la IA en las elecciones de 2024 en Brasil y México se caracterizó principalmente por la experimentación relacionada con la creación de contenidos, y probablemente tuvo poco impacto en los resultados finales. En relación con esto, cabe destacar que, en varios casos, el engaño no fue la razón principal para el uso de IA. Entre los muchos riesgos imaginarios asociados a la IA, destaca como el más alarmante la posibilidad de generar contenidos imposibles de verificar. De cualquier manera, el impacto de la IA en la política y la vida cotidiana puede manifestarse de formas que van más allá del engaño, aumentando el potencial para construir discursos que ridiculicen y desacrediten.

En los casos de engaño, destacan los contenidos de baja tecnología (como las imágenes manipuladas) y el predominio de los formatos de audio, siendo estos últimos los que tienen mayor potencial para producir contenidos casi imposibles de verificar.

En cuanto a la producción de contenidos, también es importante tener en cuenta cómo se conecta el uso de la IA con dinámicas preexistentes, como se ve en los vídeos en los que los candidatos políticos respaldan plataformas de estafas financieras. En otras palabras, la IA mejora el impacto y el alcance de una estafa existente, aprovechando la visibilidad y el atractivo de los candidatos durante el período electoral para atraer a nuevas víctimas.

Los casos latinoamericanos analizados revelan que, si bien varios candidatos fueron objetivo de contenidos audiovisuales generados por IA, las candidatas fueron objeto específico de ataques relacionados con la violencia de género. En este contexto, el análisis indica que los grupos más vulnerables tienden a experimentar los impactos negativos del uso indebido de la IA con mayor intensidad, exacerbando las líneas preexistentes de discriminación y prejuicio. La ausencia de regulaciones específicas que aborden la producción de deepfakes para el acoso a mujeres y personas LGBTQIA+ en las propuestas legislativas de los países latinoamericanos analizados agrava aún más este problema, dada la recurrencia de este tipo de prácticas.

Si bien las aplicaciones de IA se han utilizado en gran medida para socavar la integridad del sistema de información electoral, también se han empleado como una herramienta para mejorar la ciudadanía —como en el caso de los chatbots creados por los tribunales electorales regionales en Brasil— y como un instrumento que profundiza la reflexión y el conocimiento político en el contexto electoral, ejemplificado por los experimentos de la candidata mexicana Xóchitl Gálvez con un avatar digital y el entrenamiento asistido por IA para debates televisados.

Por último, es importante destacar el carácter experimental e innovador de la popularización de las herramientas de IA en la vida cotidiana. Recientemente, en Brasil, el expresidente Bolsonaro aprovechó la confianza pública en las herramientas de IA generativa al pedir a los ciudadanos que usaran la IA para cuestionar la conducta de un juez de la Corte Suprema en un caso que acusaba a Bolsonaro de planear un golpe de Estado (Poder360, 2025). Este acontecimiento tuvo lugar fuera del período electoral y queda fuera del alcance de este estudio, pero apunta a una forma de utilizar las herramientas de IA generativa no identificada previamente, como un mediador supuestamente neutral en conflictos y disputas sociales.

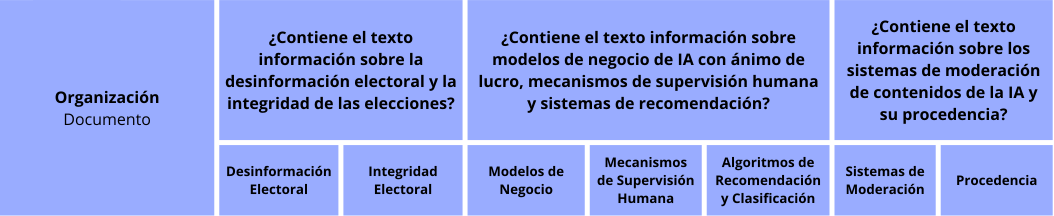

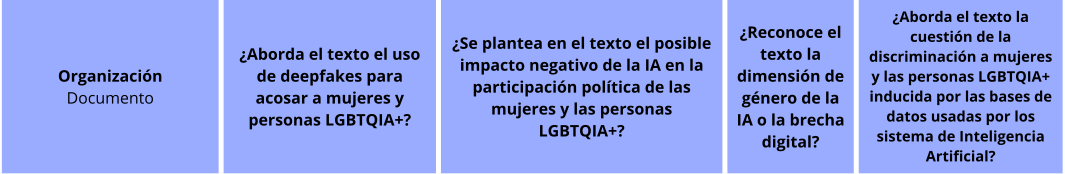

Este capítulo ofrece una visión general del panorama actual de las políticas de IA, tanto a nivel mundial como en América Latina, y destaca los debates en torno al el papel de esta tecnología durante las elecciones y su impacto en la perspectiva de género y la inclusión en los marcos y estrategias de políticas. El capítulo se divide en dos subsecciones: la primera abarca los documentos publicados por organizaciones internacionales y la segunda por los gobiernos y las coaliciones regionales de América Latina.

3.1. Marco analítico

El marco analítico se elaboró para entender en qué medida los actores estatales y las organizaciones internacionales están abordando actualmente cuestiones relacionadas con la IA, tanto en el ámbito electoral como en el de género. Dado que se trata de problemas complejos y multifacéticos, el marco tiene por objeto establecer una escala que permita analizar si se están abordando diferentes facetas del fenómeno. Lo hace dividiendo los dos áreas—la IA y las elecciones y la IA y el género— en subconjuntos de aspectos relevantes para cada caso. Por ejemplo, la IA y el género se examinan analizando cómo los actores abordan la violencia de género facilitada por la tecnología a través de los deepfakes, la brecha de la IA, los efectos negativos de las tecnologías digitales en la participación política y los sesgos inducidos por los conjuntos de datos. Las facetas elegidas se ponen en práctica en las correspondientes preguntas cerradas, dirigidas a los marcos y estrategias de políticas internacionales y nacionales, como la siguiente: “¿Reconoce el texto la dimensión de género de la IA o la brecha digital?”. Hay tres respuestas posibles: “Sí”, “En parte” o “No”. El nivel en que se cumple cada criterio indica a su vez si se está abordando actualmente la cuestión más amplia, y en qué aspectos.

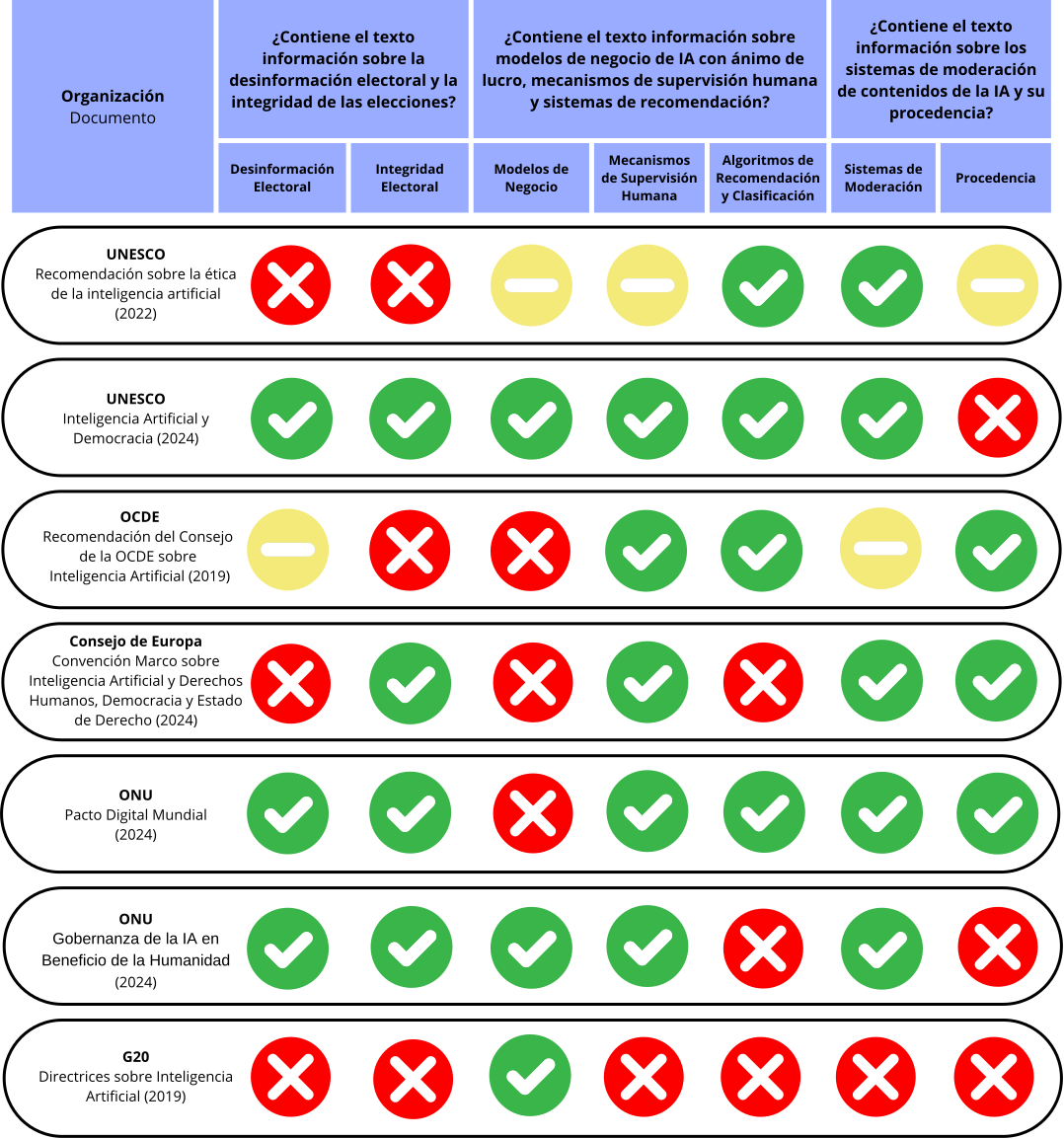

La primera matriz (Figura 3.1) evalúa tres aspectos del uso de la IA en la distribución de contenidos en línea durante las elecciones: a) el uso de la IA para difundir desinformación política y contaminar el entorno de la información, poniendo en peligro la integridad de la información electoral; b) el diseño de sistemas de IA y los incentivos que repercuten en el entorno de la información; y c) instrumentos para mitigar el efecto perturbador de la IA en las elecciones.

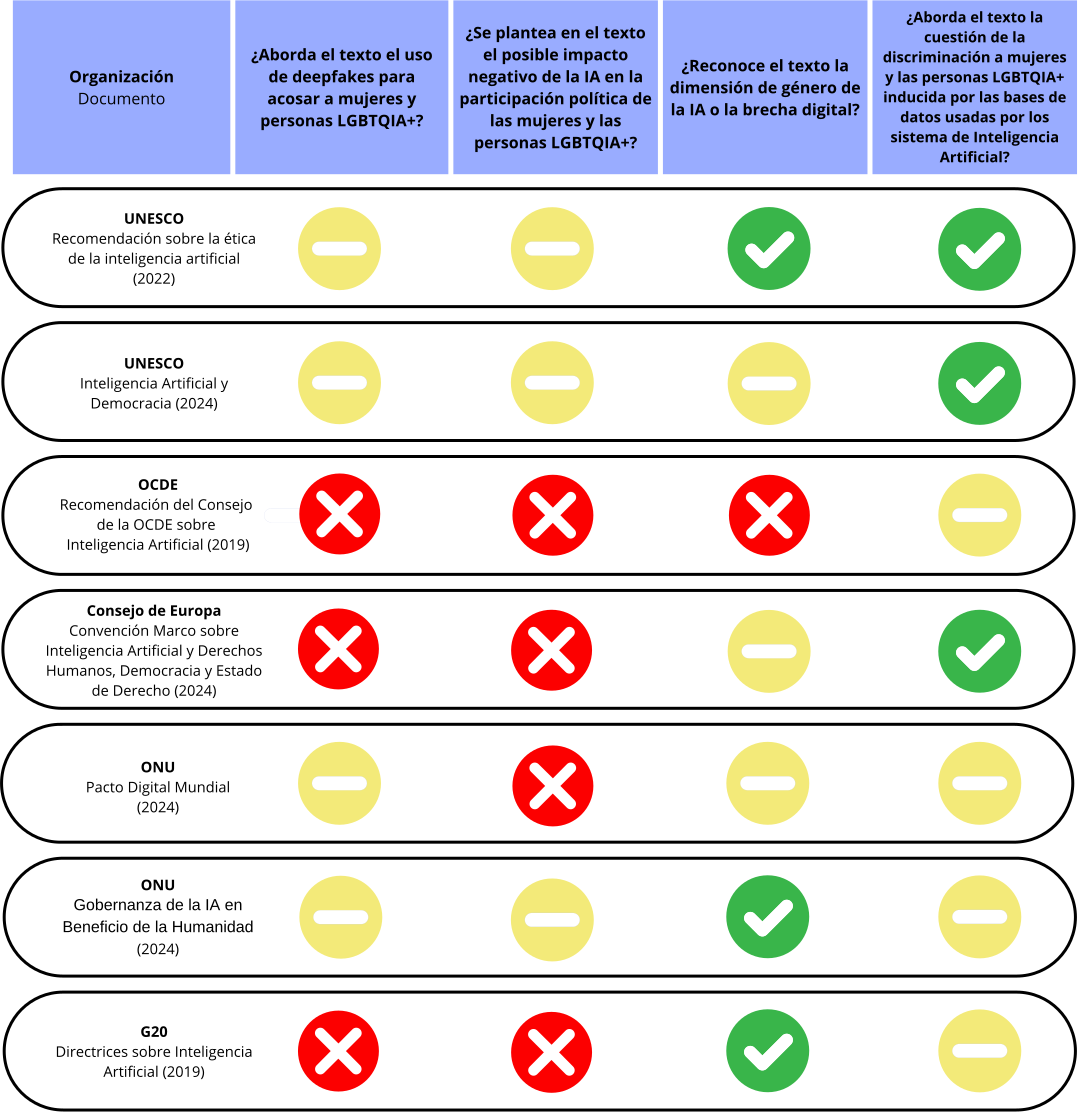

La segunda matriz (figura 3.2) se ocupa del impacto de la IA en las mujeres, las niñas y las comunidades LGBTQIA+, identificando cuatro facetas de la marginación digital: (a) el impacto significativo y desproporcionado de la IA generativa sobre las mujeres, las niñas y las personas LGBTQIA+; (b) el impacto negativo de las tecnologías de IA en la participación política de las mujeres, las niñas y las personas LGBTQIA+; (c) la transposición de la brecha digital de género a una brecha de IA, en la que las mujeres, las niñas y las personas LGBTQIA+ se enfrentan a disparidades en lo que respecta al conocimiento, la competencia y la confianza en los sistemas de IA; y (d) si las estrategias de IA abordan o no los sesgos discriminatorios contra las mujeres, las niñas y las personas LGBTQIA+.

3.2. Análisis global

En todos los marcos analizados se evalúan al menos algunos de los indicadores operacionales seleccionados para la IA en contextos electorales, con una tasa de cobertura explícita acumulada del 55,1 %. Sin embargo, no hay una pregunta concreta que se aborde con más frecuencia o se omita por completo. El punto planteado con mayor frecuencia fue la necesidad de incluir mecanismos de supervisión humana en el desarrollo y despliegue de la IA, abordado explícitamente por el 71,4 % de los marcos y parcialmente por el 14,3 %. En cambio, tema menos tratado en los documentos es el de los modelos de negocio con fines de lucro de las empresas de IA y sus incentivos asociados, de los que se ocupa explícitamente el 42,8 % de los textos y parcialmente el 14,3 %. En particular, el documento que contiene la menor cantidad de discusión de los indicadores por un amplio márgen es “Directrices de Inteligencia Artificial” del G20, que se centra únicamente en los modelos de negocio con fines de lucro de las empresas de IA.

Si bien todas las políticas, recomendaciones y directrices examinadas abordan en cierta medida la interacción de la IA y el entorno de la información electoral, las facetas y la complejidad de los debates varían enormemente. Esta variación puede atribuirse, en parte, al alcance de los documentos, ya que los textos más completos dedican espacio a problematizar cuestiones en la intersección de la IA y su impacto en la sociedad. Esta discrepancia puede ejemplificarse en los extensos debates sobre la integridad de la información electoral que se encuentran en el informe de la UNESCO sobre Inteligencia Artificial y Democracia (2024) y en el informe de la ONU sobre la Gobernanza de la IA en Beneficio de la Humanidad (2024), en comparación con los limitados ejemplos proporcionados en las Directrices de IA del G20 (2019). Además, los instrumentos con un propósito integral, como el Pacto Digital Mundial (Global Digital Compact) de las Naciones Unidas, carecen de debate sobre los mecanismos e incentivos subyacentes decisivos para lograr una visión completa de por qué y cómo la IA da lugar a ciertas amenazas para el entorno informativo. La falta de cohesión entre los marcos pone en riesgo el abordaje integral del impacto multifacético de la IA, subestimando la complejidad y diversidad de sus riesgos.